增量爬虫Mysql

定义:每次爬取只抓取新更新的链接,之前抓取过的链接不会再继续抓取

实现思路 MySQL:

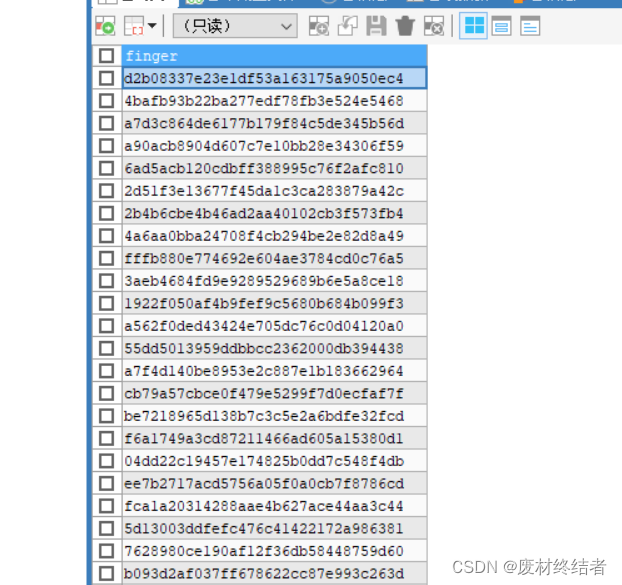

1、MySQL中新建指纹表,用来存储所有爬取过的链接的指纹

2、在爬取任何链接之前,先判断该指纹是否存在于指纹表,如果已存在则不在进行爬取

注意:

对于常规网站来说,新更新的数据一般会在最前面。比如说新闻类网站(新更新的新闻会在页面顶部)、电商类网站、房产类网站等

所以、一旦检测到有链接已经爬取过的,则无需继续再检测之后的链接,终止程序即可

知识点补充:

1、给url地址进行md5加密生成指纹

from hashlib import md5

s=md5()

s.update(url.encode())

finger=s.hexdigest()

2、pymysql模块执行查询语句后的结果

import pymysql

cursor.execute('select * from carab')

#fetchall()得到的结果为元祖

result=cursor.fetchall()

步骤:

1、创建数据库表(只爬取车的名字)

CREATE DATABASE cardb CHARSET utf8;

USE cardb;

CREATE TABLE request_finger(

finger CHAR(32)

)CHARSET=utf8;

CREATE TABLE carab(

NAME VARCHAR(100)

)CHARSET=utf8;

2、爬取程序(自行填入自己的数据库密码)

import urllib.request

import re

import time

import random

import pymysql

from hashlib import md5

import sys

class CarSpider:

def __init__(self):

self.url="https://www.che168.com/beijing/a0_0msdgscncgpi1lto1csp{}exx0/"

self.headers = {'User-Agent': 'Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; InfoPath.3; .NET4.0C; .NET4.0E'} #计数变量

self.i=0

#数据库连接相关变量

self.db = pymysql.connect(host='localhost', user='root', password='xxx', database='cardb', charset='utf8')

self.cursor=self.db.cursor()

def get_html(self,url):

"""功能函数1:获取响应内容"""

req=urllib.request.Request(url=url,headers=self.headers)

res=urllib.request.urlopen(req)

#ignore:decode()时遇到不能识别的字符,则忽略,查看网页源码看所使用的字符编码

html=res.read().decode('gb2312','ignore')

return html

def re_func(self,regex,html):

"""功能函数2:解析提取数据"""

pattern=re.compile(regex,re.S)

r_list=pattern.findall(html)

return r_list

def md5_url(self,url):

#md5加密

s=md5()

s.update(url.encode())

return s.hexdigest()

def parse_html(self,one_url):

"""数据抓取函数-从一级页面开始"""

one_html=self.get_html(one_url)

one_regex='<li class="cards-li list-photo-li ".*?<a href="(.*?)" class="carinfo".*?</li>'

#hre_list:['','']

href_list=self.re_func(one_regex,one_html)

for href in href_list:

#汽车详情页需要拼接

car_url="https://www.che168.com"+href

url_md5=self.md5_url(car_url)

sel='select * from request_finger where finger=%s'

self.cursor.execute(sel,[url_md5])

result=self.cursor.fetchall()

#判断之前是否抓取过

if not result:

#抓取一辆汽车的数据

self.get_data(car_url)

#抓取一辆车的频率,生成指定范围的浮点数

time.sleep(random.uniform(0,1))

#抓取完成之后指纹存入指纹表

ins='insert into request_finger values(%s)'

self.cursor.execute(ins,[url_md5])

self.db.commit()

else:

sys.exit("抓取完成!")

def get_data(self,car_url):

"""功能:抓取1辆汽车的数据"""

two_html=self.get_html(car_url)

two_regex='<div class="car-box">.*?<h3 class="car-brand-name">(.*?)</h3>'

#[(),]

car_list=self.re_func(two_regex,two_html)

if car_list !=[]:

item = {}

item['name'] = car_list[0].strip()

ins='insert into carab values (%s)'

self.cursor.execute(ins,[item['name']])

self.db.commit()

print(item)

def run(self):

"""程序入口函数"""

for i in range(1,4):

url=self.url.format(i)

self.parse_html(url)

self.cursor.close()

self.db.close()

if __name__=='__main__':

spider=CarSpider()

spider.run()

部分运行结果: